Ollama 推理教程

Ollama 是一个简单易用的开源本地大语言模型运行框架,支持在个人电脑上一键部署和运行各类开源模型,具有配置简单、资源占用低等特点。

随着 RWKV 社区成员 @MollySophia 的工作,Ollama 现已适配 RWKV 模型。

本章节介绍如何在 Ollama 中使用 RWKV 模型进行推理。

现在 Ollama 已经适配 RWKV-7 了!欢迎大家使用!

视频教程

高画质视频请跳转到 B 站观看。

Ollama 下载与安装

可从 Ollama 官网 下载 Ollama 的安装程序。

下载完成后,双击 exe 文件进行安装。安装完成后 Ollama 会自动启动,启动后可在系统任务栏看到 Ollama 图标。

![]()

接下来,我们将在 Ollama 中运行 gguf 格式的 RWKV 模型。从以下两种方法中选择一种:

| 方法 | 描述 | 优点 | 缺点 |

|---|---|---|---|

| 运行 Ollama 提供的 RWKV 仓库 | 从 Ollama 提供的 RWKV 仓库中下载并运行模型 | 操作简单 | Ollama 提供的 RWKV 模型只有 Q8_0 和 Q6_K 等量化版本 |

| 运行自定义 RWKV 模型 | 需要手动下载 gguf 格式的 RWKV 模型并创建 Modelfile 配置文件 | 可以运行任意量化的 RWKV 模型,包括微调的 RWKV 模型 | 需要手动配置 |

运行 Ollama 提供的 RWKV 模型

Ollama 的 RWKV 仓库提供了 RWKV7-G1b | RWKV-G0b(推荐使用) 和 RWKV7-World 模型。

RWKV-6 World 模型已过时,不再推荐使用。

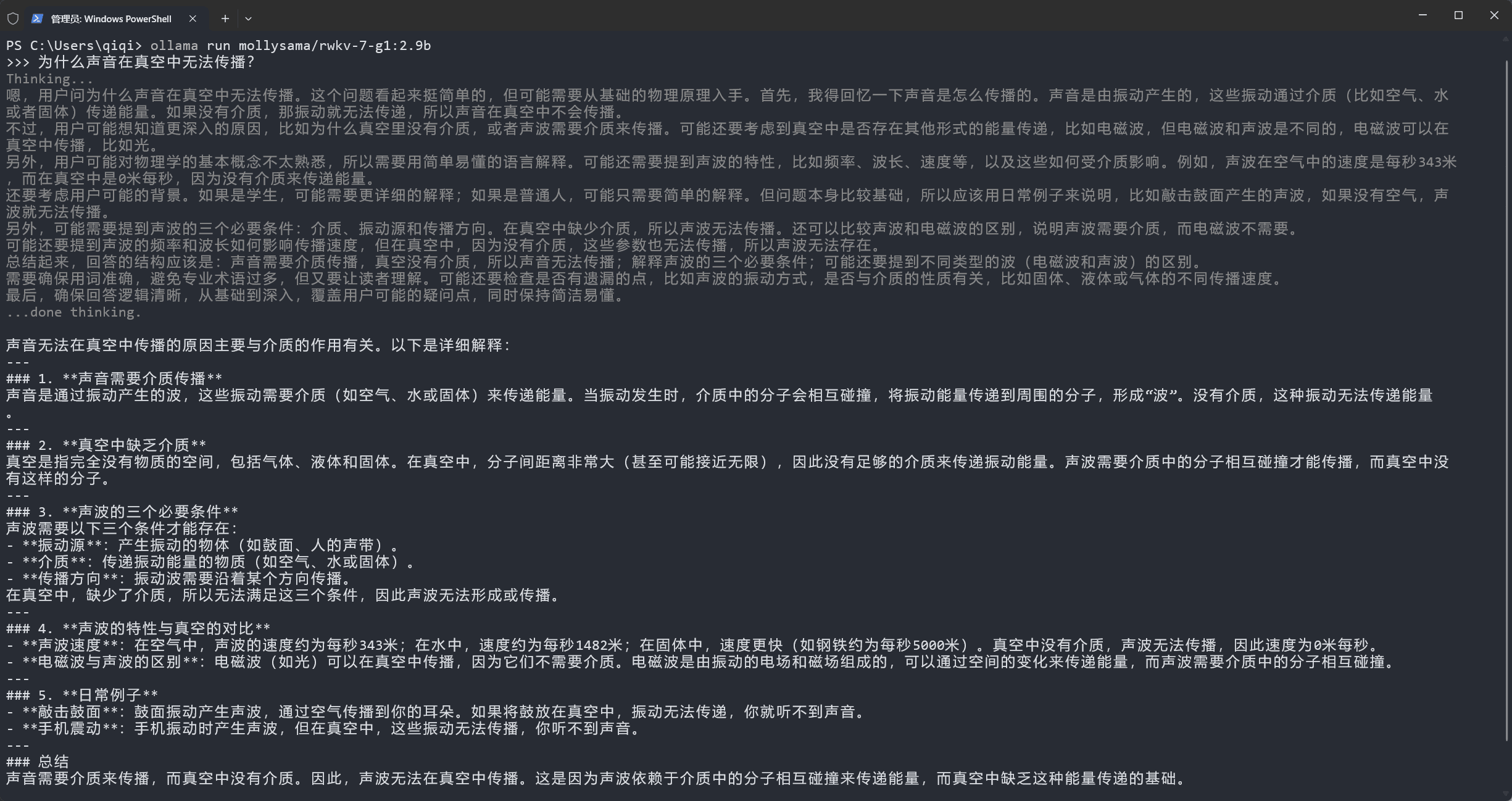

在终端中运行 ollama run mollysama/rwkv-7-g1b:2.9b 命令,Ollama 将自动下载并运行 RWKV7-G1b 2.9B 模型。您可以在终端中与 RWKV 模型进行对话。

RWKV7-G1 系列模型默认开启思考模式,可以通过 /set nothink 和 /set think 命令灵活地开关思考模式。

RWKV7-G1 模型是 RWKV-7-World 模型的全面升级,推荐使用 RWKV7-G1 模型。

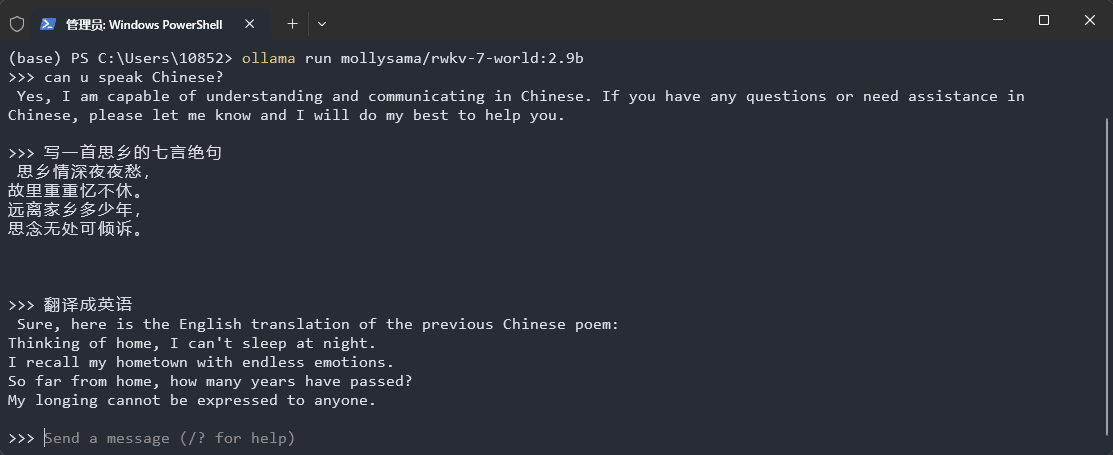

在终端中运行 ollama run mollysama/rwkv-7-world:2.9b 命令,Ollama 将自动下载并运行 RWKV7-World 2.9B 模型。您可以在终端中与 RWKV 模型进行对话,如下图所示:

所有可选的 Ollama/RWKV-7 World 模型:

mollysama/rwkv-7-world:1.5b:量化精度为Q4_K_Mmollysama/rwkv-7-world:2.9b:量化精度为Q4_K_M

若您曾经下载过 mollysama/rwkv-7-world:2.9b 模型,请运行 ollama pull mollysama/rwkv-7-world:2.9b 命令,拉取最新的变更。

运行自定义 RWKV 模型

要运行一个自定义的 RWKV 模型,你需要一个 .gguf 格式的模型文件,和一个用于配置聊天模板和解码参数的 Modelfile 文件。然后使用 ollama create 命令创建一个自定义 Ollama 模型。

创建完毕后,即可使用 ollama run 命令运行自定义模型。

下载 RWKV gguf 模型

可以从 ModelScope - RWKV GGUF 合集 下载 gguf 格式的 RWKV 模型。

RWKV gguf 模型有各种量化版本,建议使用 FP16、 Q8_0 两种量化精度,更低的量化精度(如 Q5_K_M、Q4_K_M 等)可能会使模型的回答变差。

自己微调了一个 RWKV-7 模型,想从 pth 格式转 gguf?查看 从 pth 模型转换为 gguf。

创建模型的 Modelfile 文件

在存放 RWKV gguf 模型文件的文件夹下创建名为 Modelfile 的文本文件,不需要后缀名。

![]()

使用“记事本”等文本编辑工具打开 Modelfile,然后根据模型是否支持思考模式创建不同的 Modelfile 文件。

RWKV G0/G1 系列推理模型同时支持“思考”和“不思考”两种模式,因此下列两种 Modelfile 都可用,根据您对推理功能的需求选择其中一种即可。

对于 RWKV G0/G1 系列支持思考功能的 RWKV 模型,请在 Modelfile 中写入以下内容:

`FROM rwkv7-g1b-2.9b-20251205-ctx8192-FP16.gguf

TEMPLATE """{{- if .System }}System: {{ .System }}{{ end }}

{{- range $i, $_ := .Messages }}

{{- $last := eq (len (slice $.Messages $i)) 1}}

{{- if eq .Role "user" }}

{{- if eq $i 0}}User: {{ .Content }}{{- else }}

User: {{ .Content }}{{- end }}

{{- else if eq .Role "assistant" }}

Assistant: <{{- if and $last .Thinking -}}think>{{ .Thinking }}</think>{{- else }}think>

</think>{{- end }}{{ .Content }}{{- end }}

{{- if and $last (ne .Role "assistant") }}

Assistant:{{- if $.IsThinkSet }} <{{- if not $.Think }}think>

</think>{{- end }}{{- end }}{{- end }}{{- end }}"""

PARAMETER stop """

"""

PARAMETER stop """

User"""

PARAMETER stop "User"

PARAMETER stop "Assistant"

PARAMETER temperature 1

PARAMETER top_p 0.5

PARAMETER repeat_penalty 1.2`如果不需要思考模式(RWKV-World 系列模型不支持思考功能,因此只能使用此模板),请在 Modelfile 中写入以下内容:

`FROM rwkv7-g1b-2.9b-20251205-ctx8192-FP16.gguf

TEMPLATE """{{- if .System }}System: {{ .System }}{{ end }}

{{- range $i, $_ := .Messages }}

{{- $last := eq (len (slice $.Messages $i)) 1}}

{{- if eq .Role "user" }}

{{- if eq $i 0}}User: {{ .Content }}{{- else }}

User: {{ .Content }}{{- end }}

{{- else if eq .Role "assistant" }}

Assistant:{{ .Content }}{{- end }}

{{- if and $last (ne .Role "assistant") }}

Assistant:{{- end -}}{{- end }}"""

PARAMETER stop """

"""

PARAMETER stop """

User"""

PARAMETER temperature 1

PARAMETER top_p 0.5

PARAMETER repeat_penalty 1.2`请将第一行 FROM 之后的 rwkv-xxx.gguf 修改为你本地的 RWKV 模型文件名称。PARAMETER temperature 1、PARAMETER top_p 0.5 等解码参数可以根据需要进行调整。

创建并运行自定义 RWKV 模型

在存放 RWKV gguf 模型和 Modelfile 文件的目录下打开终端,并执行 ollama create 命令:

ollama create rwkv7-g1b-2.9b-20251205-ctx8192-FP16 -f Modelfile将 ollama create 后面的模型名称改成你本地的 RWKV 模型(与 Modelfile 中的模型名称保持一致),但无需 .gguf 后缀名。

创建完毕后,使用 ollama run 命令直接运行模型:

ollama run rwkv7-g1b-2.9b-20251205-ctx8192-FP16成功运行后,即可与模型进行聊天对话。

关闭 Ollama

请使用 ollama stop rwkv-model-name 命令停止当前模型实例,从而重置对话上下文。

如果你不需要停止当前模型,而是想要开始一轮全新的对话,则可以使用 /clear 命令清除当前模型的上下文(历史消息)。

Ollama GUI 和桌面程序

Ollama 本身并没有提供 GUI 或 WebUI 服务,但其社区提供了第三方 GUI 和桌面程序。

可以在 Ollama 的 GitHub 文档 中查看所有第三方 Ollama 工具。